"算力"作为当代生产力的象征,已经成为业界的普遍认同。数据中心基础设施,尤其是算力服务器,作为数据要素的核心载体和产业融合的桥梁,正在发挥着类似水和电在产业赋能和企业数字化转型中的基础性作用。它们不仅为产业提供动力,更是中国数字经济高质量发展和推动新生产力发展的关键技术基础。

在这一背景下,去年10月,国家发布了《算力基础设施高质量发展行动计划》,其中设定了到2025年的发展目标。该计划明确提出,算力规模将超过300 EFLOPS,智能算力占比目标为35%,并推动东西部算力的平衡协调发展。此外,通过应用赋能,计划将催生一系列新场景、新业态和新模式,标志着我国算力产业正式迈入了高速发展的新纪元。人工智能(AI)算力,作为这一进程中的核心驱动力,已成为数字经济"主航道"上的关键因素。

但也要看到,当前整个社会的算力供需关系依然紧张,千行万业的数智化转型浪潮一波接一波的涌现,以大模型为代表的AI技术生态爆发式增长,都让算力鸿沟不断扩大。数据显示,传统算力时代,算力需求每18-20个月翻一倍,在深度学习出现之后,算力需求每6个月翻一倍,而到了大模型时代,对算力特别是AI算力的需求几乎是每年数百倍的增长。

我们同样需要认识到,目前社会对算力的需求与供给之间存在紧张关系。随着各行各业数字化转型的浪潮不断涌现,以大型模型为代表的人工智能技术生态正在经历爆炸式增长,这进一步加剧了算力资源的缺口。相关数据显示,在传统算力时代,算力需求大约每18到20个月翻一番。然而,随着深度学习技术的出现,这一周期缩短至每6个月翻一番。进入大型模型时代后,特别是对人工智能算力的需求,呈现出每年数百倍的惊人增长速度。这种迅猛的增长对算力基础设施提出了更高的要求,也凸显了优化算力资源分配和提升算力供给能力的重要性。

AI时代算力迎来全新挑战

人工智能对人类社会来说并不是一项简单的技术革命,它象征着一个时代的到来,如同工业时代之于农业时代一样,会带来天翻地覆的变革,影响人类社会百年、甚至千年的进程。

而AI算力对于推动人工智能应用的重要性毋庸置疑,特别是随着今年整个生成式AI和大模型的爆发,不仅带来了对算力基础设施的巨大需求,同时更让本就供需不平的算力产业结构进一步“承压”,而这让算力基础设施迎来了全新的挑战,主要体现在以下几个方面:

一是,生成式人工智能(AI)和大型模型的崛起,正推动着对算力资源的巨大需求,为AI的持续发展提供动力。这些AI大模型的创新性发展,无论是在训练还是推理阶段,都对算力提出了前所未有的需求。随着模型参数规模的显著增长,算力市场的供需关系面临日益严峻的挑战。特别是,训练和推理的算力需求正在以指数级的速度增长,预示着未来对边缘计算和端侧算力的巨大潜在需求。

此外,预训练大型模型的实施,不仅需要庞大的数据资源,还需要高性能服务器的持续高效运行。这一需求对算力基础设施的多个方面提出了更高标准,包括网络带宽、能源效率、散热技术、数据存储解决方案以及数据安全保护等。这些要求推动了对基础设施软硬协同能力的提升,以确保AI技术能够在一个更加强大和可靠的平台上发展。

二是,算力基础设施的运维和运营模式正迎来一场全面的革新,以适应AI时代的快速发展需求。运维作为算力基础设施生命周期管理的关键环节,正经历着以下几方面的转变:

首先,随着运维数据量的激增,智能运维技术如Dell AIOps等日益普及。这些技术不仅与监控、服务台和自动化系统实现联动,而且能够从多个系统中提取数据,以服务为导向,为决策提供支持,成为行业发展的新趋势。

其次,运维与安全领域的融合日益加深。隐私数据、流转数据以及人的行为数据等,正逐渐成为日常运维工作的一部分,这要求运维团队不仅要关注系统的正常运行,还要确保数据的安全性和合规性。

此外,从运营模式的角度来看,面向下一代数据中心的建设、能源使用、规划布局以及技术创新等方面,都面临着新的挑战和机遇。这要求数据中心的运营者不断探索新的解决方案,以提高能效、优化资源配置,并推动技术创新,从而满足AI时代对算力基础设施的高标准要求。

三是,节能减排也是算力基础设施面临的重大挑战。我们知道,一直以来数据中心作为“能耗大户”,其建设和发展过程中也带来了巨大的能耗挑战。根据前瞻产业研究院分析数据显示,过去十年,我国数据中心整体用电量以每年超过10%的速度递增。截至2020年,数据中心约占我国用电量的2.7%,而预计到2024年数据中心耗电量将占到全社会耗电量的5%以上。因此,在国家“双碳”战略的背景下,无论是算力基础设施,还是数据中心产业也需要以降碳为目标,走向低碳化、绿色化的发展阶段,由此才能够支撑起千行万业走向“低碳”高质量发展的创新之路。

不难看出,在全新的AI时代,全新的要求都让以算力服务器为代表的数据中心基础设施亟待通过新一轮的变革与创新,进一步推动现代化数据中心的进化与演进,才能为千行万业的数智化转型提供更为坚实的保障。

夯实AI时代的“算力底座”

也正是洞察到这种市场变化,作为全球领先的科技企业,戴尔科技通过推动算力基础设施产品和解决方案的技术创新,打造“端到端AI平台解决方案”,可以说为企业的数智化转型和激发新质生产力,夯实了AI时代的“算力底座”。

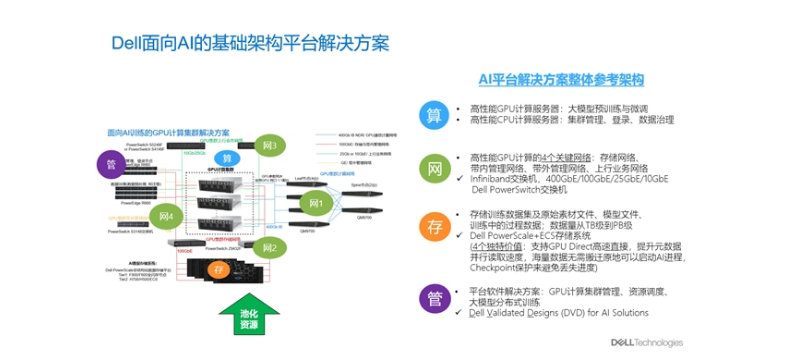

在戴尔科技集团信息基础架构解决方案事业部AI企业技术架构师、全球CTO大使吴跃看来,无论是哪种AI应用,背后都离不开AI算力与AI基础架构平台的支持。基于此,戴尔科技打造了面向AI的基础架构平台解决方案,并围绕“算、网、存、管”提供整体参考架构,以“端到端”的创新方式帮助企业级用户应对不同算力场景下的需求挑战:

首先,基于戴尔PowerEdge AI加速计算平台,戴尔科技科提供多元化的AI加速计算选型支持。GPU是当前AI计算中使用最广泛、最成熟的加速计算技术。为此,戴尔新一代PowerEdge(16G)先后推出了多款专门针对GPU计算设计和优化的专业服务器,可为企业提供GPU分布式训练解决方案、GPU池化解决方案以及边缘AI计算解决方案等,支持企业面向AI的端到端训练、微调、推理以及面向传统AI(如机器视觉、语音识别)的模型训练及推理场景。

不仅如此,为了更好的释放算力资源,戴尔PowerEdge 16G服务器平台面向AI GPU计算还做了专门的优化设计,其中在机柜空间方面,通过更加紧凑的机箱设计, PowerEdge XE9680 的6U空间可以支持8张通过NVLink高速互连的NVIDIA最新GPU;在供电方面,通过对GPU与CPU模组的统一供电,实现了电源峰值功率140%-170%增强设计,更好地应对GPU开机启动风暴及GPU实际运行功耗可能会超出额定功率的现象;同时,在散热方面,也通过多矢量散热技术,实现了动态调整冷却风强度;此外,在安全性和可管理型方面,戴尔PowerEdge 16G服务器也是基于零信任原则设计的服务器平台,具备更强的安全性和抗风险能力,而可管理性方面,通过iDRAC带外管理卡功能,也可以动态监控GPU的运行状态(功率/温度/散热等),GPU碳足迹的追踪报告等。

凭借强大的性能和优秀的设计,在2023年9月正式发布的MLPerf Inference v3.1 AI推理基准测试中,Dell PowerEdge GPU加速服务器在Datacenter Closed赛道项目中,取得了图像分类(ResNet-50)、语音识别(RNN-T)、自然语言处理(BERT)、推荐系统(DLRM)等7个项目的性能测试第一名。

值得一提的是,基于戴尔PowerEdge + Intel Xeon Max解决方案,戴尔科技还可提供无需GPU亦可支撑的AI加速计算,更好的满足企业在模型微调和模型推理场景中的需求,其优势在于能够显著加速内存带宽密集型业务,同时通用性更强,成本更低。

其次,针对AI全生命周期的数据管理,戴尔科技通过“数据湖存储+GPU加速训练”的方式,一站式满足企业级用户的需求,最大化加快企业的创新步伐,以满足当今、未来以及接下来任何挑战的需求。

在这方面,戴尔科技推出了专为AI打造的新一代PowerScale全闪存节点,这是全球首个率先通过NVIDIA SuperPOD验证的以太网存储平台,借助这个全新的平台,企业可以加快创新速度,以更高的灵活性和安全性部署AI应用,同时利用高速的NVIDIA Spectrum以太网技术加速数据访问并借助智能横向扩展实现性能最大化。

除此之外,作为构建AI数据平台的关键底座,PowerScale“横向扩展存储家族”发展至今,其阵容也非常强大,能够为企业提供更加多元化的选择,包括定位“综合性”的PowerScale A300/A3000;定位“平衡性”的PowerScale H700/H7000,以及定位“性能型”的PowerScale F900、F600以及F200。

成都戴尔总代理一直以客户需求为导向,不断提供最新最全的产品与性价比更高的PowerEdge服务器、Precision工作站解决方案。了解更多产品信息及戴尔EMC最新动态,可拨打客服专线:028-85024766、18215624006或登录公司官方网站www.dellzd.com ,与全球戴尔易安信用户共同见证卓越。